مقاله تحقیقاتی جدید از اوپنایآی که پنجشنبه منتشر شده است میگوید که یک هوشمصنوعی فوق بشری در راه است و این شرکت در حال توسعه ابزارهایی است تا اطمینان حاصل کند که این هوشمصنوعی علیه انسانها نمیشود! ایلیا ساتسکور، دانشمند ارشد اوپنایآی، به عنوان نویسنده اصلی در مقاله ذکر شده است، اما نه پست وبلاگی که همراه آن بود، و نقش او در این پروژه همچنان نامشخص است.

اوپنایآی در یک پست وبلاگی گفته که معتقد است ابرهوش یا همان هوشمصنوعی بسیار هوشمندتر از انسان، میتواند در ده سال آینده توسعه یابد. پی بردن به اینکه چگونه میتوان سیستمهای هوشمصنوعی فوق بشری آینده را ایمن کرد، هرگز مهمتر از اکنون نبوده است، اما در حال حاضر میتوان پیشرفت تجربی در این پروژه آسانتر از همیشه است.

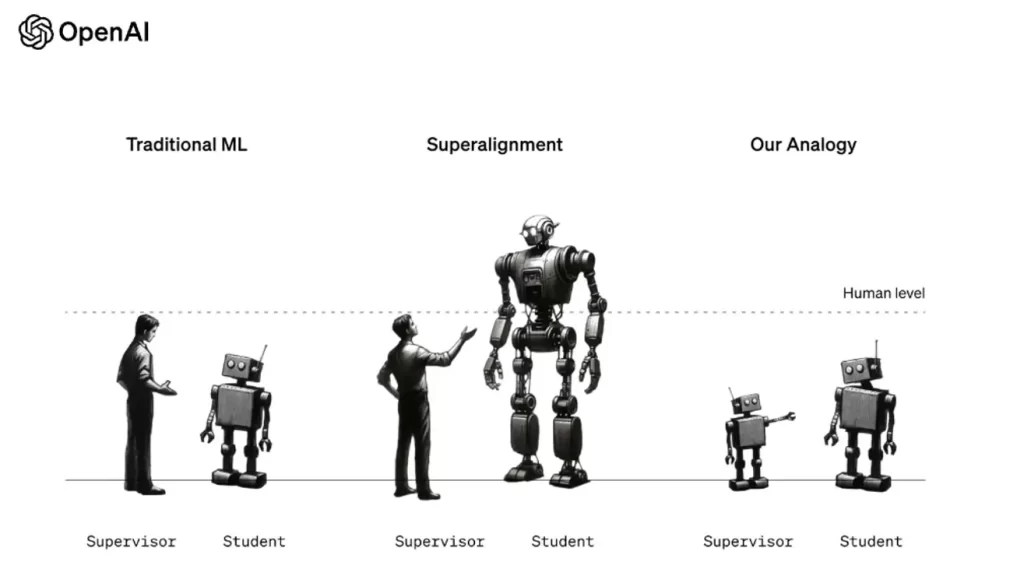

«تعمیم ضعیف به قوی» اولین مقاله از تیم «Superalignment» ایلیا سوتسکور و یان لیک است که در ماه جولای برای اطمینان از اینکه سیستمهای هوش مصنوعی بسیار باهوشتر از انسانها همچنان از قوانین انسانی پیروی میکنند، ایجاد شد. راه حل پیشنهادی؟ اوپنایآی نیاز به طراحی مدلهای کوچک هوش مصنوعی برای آموزش مدلهای هوش مصنوعی فوقانسانی دارد.

در حال حاضر، اوپنایآی از انسانها برای «همسو کردن» چتجیپیتی با دادن بازخورد خوب یا بازخورد منفی استفاده میکند. به این ترتیب اوپنایآی تضمین میکند که چتجیپیتی دستورالعملهایی درباره نحوه ساخت بمب ناپالم در خانه یا سایر نتایج خطرناک به مردم نمیدهد. با این حال، همانطور که چتجیپیتی هوشمندتر میشود، اوپنایآی اذعان میکند که انسانها برای آموزش این مدلها کافی نخواهند بود، بنابراین باید یک هوشمصنوعی پیچیدهتر را آموزش دهیم تا این کار را از طرف ما انجام دهد.

این اولین نشانه وجود ایلیا ساتسکور در اوپنایآی است، اما از زمانی که سم آلتمن اعلام کرد تقریباً همه به اوپنایآی بازگشتهاند در حالی که وضعیت ساتسکور در هوا باقی مانده است. ساتسکور، یکی از بنیانگذاران اوپنایآی، یکی از اعضای هیئت مدیره زمان اخراج آلتمن بود. در حال حاضر او دیگر جزو هیئت مدیره شرکت نیست، اما ممکن است هنوز نقشی در پروژهها داشته باشد.

منابع به Businessinside.com گفتهاند که او در چند هفته گذشته در شرکت نامرئی بوده و وکیل استخدام کرده است. جان لیک و سایر اعضای تیم Superalignment اوپنایآی در این مقاله مهم اظهارات عمومی کردند، اما ساتسکور یک کلمه هم نگفته است و فقط ریتوییت میکند.

این مطالعه نشان داد که آموزش مدلهای هوش مصنوعی بزرگ با مدلهای هوشمصنوعی کوچکتر، چیزی که آنها «تعمیم ضعیف به قوی» مینامند، در مقایسه با آموزش انسانی، در شرایط مختلف دقت بالاتری را به همراه دارد. بیشتر مطالعه از GPT-2 برای آموزش GPT-4 استفاده کرد. توجه به این نکته مهم است که اوپنایآی میگوید متقاعد نشده است که این یک راهحل برای همسویی بهتر است، بلکه این فقط یک چارچوب امیدوارکننده برای آموزش یک هوش مصنوعی فوقانسانی است.

محققان اوپنایآی در این مطالعه گفتند: «مدلهای مافوق بشری فوقالعاده قدرتمند خواهند بود و در صورت استفاده نادرست یا ناهماهنگی با ارزشهای انسانی، میتوانند به طور بالقوه آسیب فاجعهباری ایجاد کنند.» ما معتقدیم که اکنون پیشرفت در این پروژه آسانتر از همیشه است.»

حدس و گمان قابل توجهی وجود داشت مبنی بر اینکه اوپنایآی در ماه نوامبر به AGI نزدیک شده بود، اگرچه بسیاری از آن بینتیجه بودند. این مقاله تأیید میکند که اوپنایآی به طور فعال در حال ساخت ابزارهایی برای کنترل یک AGI است، اما وجود یک AGI را تأیید نمی کند. در مورد ایلیا سوتسکور، وضعیت او در برزخ عجیبی باقی مانده است. اوپنایآی موقعیت خود را در این شرکت تایید نکرده است، اما تیم او بی سر و صدا تحقیقات پیشگامانهای را در حالی که او اعلامیههای شرکت خود را ریتوییت میکند، پیش برده است.

بیشتر بخوانید:

on تیمی در اوپنایآی ابزارهای کنترل هوشمصنوعی ابرانسان ساختند!