در سالهای اخیر، هوش مصنوعی مولد جهان را به شدت تحت تأثیر قرار داده است. این مدل های قدرتمند می توانند متن، تصاویر و حتی کدهایی ایجاد کنند که اغلب با محتوای ساخته شده توسط انسان رقابت می کنند. از چتباتهایی که میتوانند در مکالمات انسانمانند شرکت کنند تا مولدهای تصویر که میتوانند تصاویری خیرهکننده تولید کنند، قابلیتهای خلاقانه هوش مصنوعی بی حد و حصر به نظر میرسد.

اما وقتی این مدلهای هوش مصنوعی شروع به یادگیری از خلاقیتهای خود کنند، چه اتفاقی میافتد؟ محققان پدیدهای به نام «فروپاشی مدل» را کشف کردهاند که در آن سیستمهای هوش مصنوعی آموزشدیده بر روی محتوای تولید شده توسط هوش مصنوعی شروع به تولید خروجیهای بی معنی میکنند.

این موضوع که اخیراً در مقالهای توسط Shumailov و همکاران برجسته شده است، پارادوکس شگفت انگیزی را در دنیای هوش مصنوعی ارائه می دهد. زمانی که این مدلها بیشتر از خروجی خودشان مصرف میکنند، در خطر کمهوشی و کمتر نماینده دنیای واقعی هستند که برای درک و تقلید طراحی شدهاند.

در این پست، مفهوم فروپاشی مدل، پیامدهای آن برای آینده هوش مصنوعی، و چالش هایی که برای توسعه دهندگان و کاربران ایجاد می کند را بررسی خواهیم کرد.

مشکل: فروپاشی مدلهای هوش مصنوعی

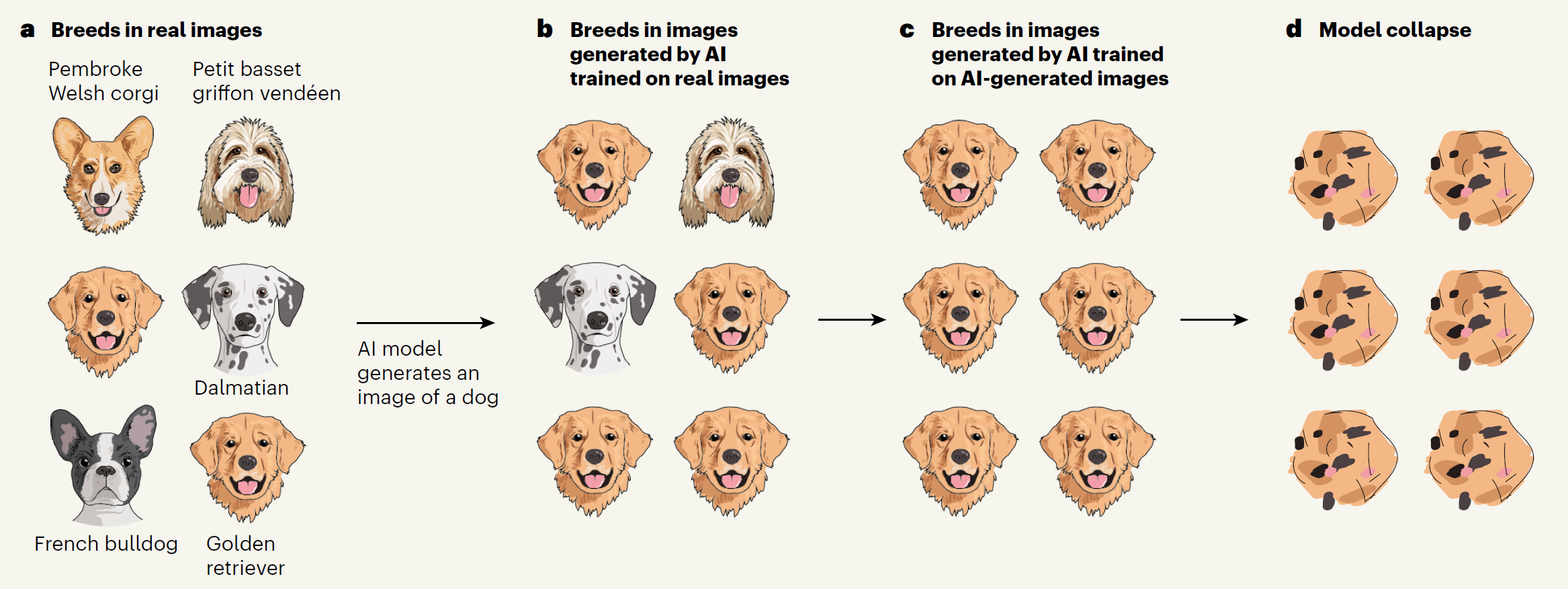

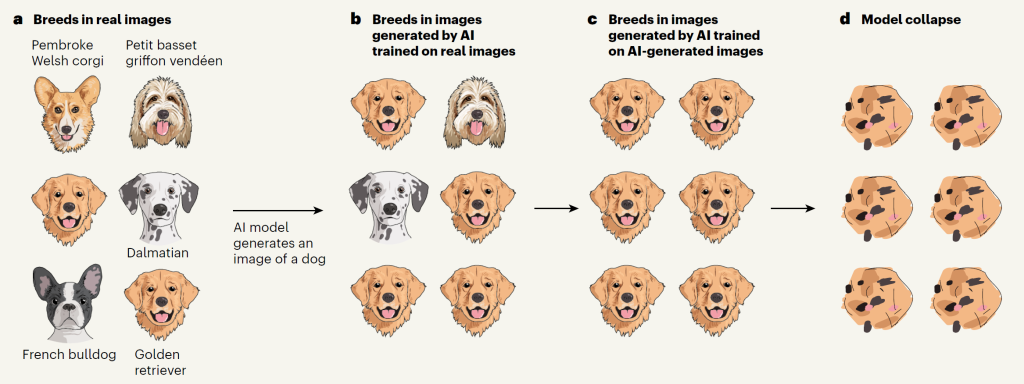

یک مدل هوش مصنوعی را تصور کنید که وظیفه دارد تصاویری از سگ ها تولید کند. این سگ که در ابتدا بر روی مجموعه ای متنوع از عکس های واقعی سگ آموزش دیده بود، نژادهای مختلفی تولید می کند. با این حال، همانطور که به طور مکرر بر روی خروجی های خود آموزش داده می شود، یک پدیده عجیب رخ می دهد. این مدل شروع به طرفداری از نژادهایی که بیشتر دیده است مانند گلدن رتریور می کند، در حالی که به تدریج نژادهای کمیاب تر را “فراموش می کند”.

پس از چندین دوره از این خودآموزی، این مدل ممکن است تنها رتریورهای طلایی تولید کند، زیرا توانایی نمایش نژادهای کمتر رایج را از دست داده است. این روند را بیشتر ادامه دهید، و خروجی ها غیرقابل تشخیص می شوند – شاید حباب های سگ مانندی که به سختی شبیه سگ های سگ واقعی هستند.

این مثال ساده، موضوع گسترده تری را در توسعه هوش مصنوعی نشان می دهد. وقتی مدلهای زبان بزرگ (LLM) بر اساس محتوای تولید شده خود آموزش داده میشوند، تمایل دارند الگوهای رایج را تقویت کنند و تفاوتهای ظریف را از دست بدهند. با گذشت زمان، این منجر به “فروپاشی” می شود، که در آن مدل خروجی های عمومی، تکراری یا بی معنی به طور فزاینده ای تولید می کند.

از آنجایی که محتوای تولید شده توسط هوش مصنوعی به اینترنت سرازیر می شود، مدل های آینده هوش مصنوعی که بر روی این داده ها آموزش دیده اند، خطر به ارث بردن و تقویت این سوگیری ها را دارند. نتیجه؟ یک اتاق پژواک دیجیتال که در آن سیستمهای هوش مصنوعی محدودیتهای خود را تقویت میکنند و به طور بالقوه تنوع و پیچیدگی دانش و بیان انسان را از بین میبرند.

اهمیت

پیامدهای فروپاشی مدل بسیار فراتر از حوزه کنجکاوی فنی است:

- انصاف و بازنمایی: از آنجایی که مدلها عناصر کمتر رایج را از دادههای آموزشی خود فراموش میکنند، خطر بازنمایی یا حذف کامل دیدگاهها، فرهنگها و تجربیات اقلیت را دارند. این میتواند به سیستمهای هوش مصنوعی منجر شود که عمدتاً دیدگاههای اکثریت را برآورده میکنند و تعصبات اجتماعی موجود را تشدید میکنند.

- از دست دادن دانش: اطلاعات کمیاب اما ارزشمند ممکن است در سر و صدای دانش مشترک که مکرراً تقویت می شود از بین برود. این می تواند توانایی هوش مصنوعی را برای کمک به کارهای تخصصی یا ارائه بینش در مورد موضوعات خاص محدود کند.

- تأثیر بر توسعه هوش مصنوعی: این تحقیق نشان میدهد که مدلهای اولیه هوش مصنوعی که بر روی دادههای اینترنتی قبل از هوش مصنوعی آموزش دیدهاند ممکن است در نمایش پیچیدگی دنیای واقعی برتری داشته باشند. این می تواند زمینه بازی ناهمواری در توسعه هوش مصنوعی ایجاد کند و به طور بالقوه قدرت را در دستان چند رهبر اولیه متمرکز کند.

- اعتماد و قابلیت اطمینان: از آنجایی که هوش مصنوعی به طور فزاینده ای در جنبه های مختلف زندگی ما، از تولید محتوا گرفته تا سیستم های تصمیم گیری، ادغام می شود، قابلیت اطمینان خروجی های آن بسیار مهم می شود. فروپاشی مدل می تواند منجر به سیستم های هوش مصنوعی کمتر قابل اعتماد شود و به طور بالقوه اعتماد عمومی به فناوری هوش مصنوعی را تضعیف کند.

با درک و پرداختن به چالش فروپاشی مدل، میتوانیم در جهت ایجاد سیستمهای هوش مصنوعی که واقعاً هوش انسان را تقویت میکنند، به جای اینکه صرفاً نسخهای که به طور فزایندهای تحریف شده از آن منعکس شود، کار کنیم. مسیر پیش رو مستلزم توجه دقیق به نحوه آموزش مدل های هوش مصنوعی و داده هایی است که برای انجام این کار استفاده می کنیم.

راه حل ها و چالش های بالقوه

پرداختن به فروپاشی مدل ساده نیست، اما محققان در حال بررسی چندین رویکرد هستند:

- واترمارک: یکی از راه حل های پیشنهادی تعبیه واترمارک های نامرئی در محتوای تولید شده توسط هوش مصنوعی است. این به فرآیندهای آموزشی آینده اجازه می دهد تا داده های ایجاد شده توسط هوش مصنوعی را شناسایی و فیلتر کنند و یکپارچگی مجموعه داده های آموزشی را حفظ کنند. با این حال، این استراتژی با موانع قابل توجهی مواجه است. تحقیقات اخیر نشان می دهد که این نشانگرها را می توان به راحتی از تصاویر تولید شده توسط هوش مصنوعی حذف کرد. علاوه بر این، اجرای موثر نیازمند همکاری بیسابقهای میان شرکتهای هوش مصنوعی است، که ممکن است تمایلی به اشتراکگذاری اطلاعات اختصاصی نداشته باشند یا بهطور بالقوه در چشمانداز رقابتی هوش مصنوعی دچار ضرر شوند.

- دادههای آموزشی متنوع: اطمینان از متنوع بودن مجموعه دادههای آموزشی و معرف پیچیدگی دنیای واقعی بسیار مهم است. این ممکن است شامل تنظیم دقیق داده های آموزشی یا توسعه روش هایی برای حفظ اطلاعات کمیاب اما مهم در طول فرآیند آموزش باشد. نمونه این استراتژی را می توان در رسپي آموزشی مدل AlphaFold3 مشاهده کرد. در هنگام آموزش این مدل محققان مشاهده کردند که یکسری قابلیت ها در طول تمرین تقویت و بعضی تضعیف می شوند و برای حل این مدل سمپلینگ داده های مربوط به قابلیت هایی که در حال تضعیف بودند را تغییر دادند.

- بازنشانی منظم مدل: بازآموزی دورهای مدلها در مجموعه دادههای اصلی و با کیفیت میتواند به جلوگیری از انباشت سوگیریها و از دست دادن اطلاعات در طول زمان کمک کند.

جمعبندی

پدیده فروپاشی مدل به عنوان یادآوری آشکار از پیچیدگی های موجود در توسعه سیستم های هوش مصنوعی واقعاً هوشمند و قابل اعتماد است. از آنجایی که محتوای تولید شده توسط هوش مصنوعی به طور فزاینده ای رایج می شود، ما با یک مقطع حساس در تکامل هوش مصنوعی روبرو هستیم.

پرداختن به این چالش نیازمند رویکردی چندوجهی است که راه حل های فنی را با ملاحظات اخلاقی ترکیب می کند. ما باید تلاش کنیم تا سیستمهای هوش مصنوعی ایجاد کنیم که نه تنها از دامهای تعصبات خود-تقویتکننده جلوگیری کند، بلکه درک ما از جهان را با همه تنوع و پیچیدگیاش افزایش دهد.

آینده هوش مصنوعی به توانایی ما برای عبور از این چالش ها بستگی دارد. با تقویت همکاری بین محققان، توسعهدهندگان، محققین اخلاق و سیاستگذاران، میتوانیم به سمت سیستمهای هوش مصنوعی کار کنیم که واقعاً هوش انسانی را تکمیل و گسترش میدهند.

on از تنوع تا یکنواختی: بحران فروپاشی مدل